An generativer KI kommt auch der Prototype Fund nicht vorbei. In den vergangenen Bewerbungsrunden sind immer mehr Bewerbungen für Projekte eingegangen, die Methoden der Künstlichen Intelligenz (KI) bei der Entwicklung nutzen oder kritisch begleiten. Deshalb haben wir als Förderprogramm uns in unserem Trendbericht Generative KI in der Hand der Zivilgesellschaft mit dem Thema auseinandergesetzt. Einige der Ergebnisse stellen wir in unserer vierteiligen Blogreihe vor.

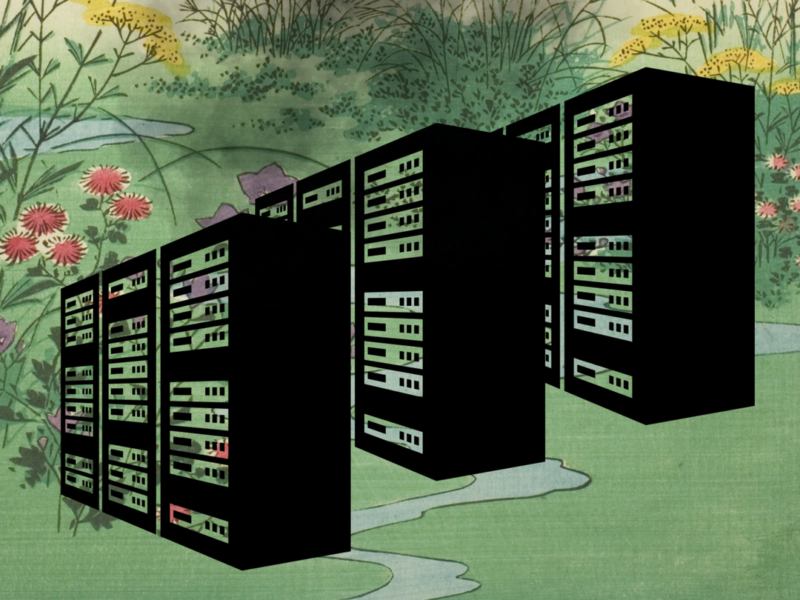

Generative KI-Systeme zu entwickeln, ist sehr ressourcenintensiv. Das hat nicht nur Auswirkungen auf Umwelt und Klima, der hohe Ressourcenverbrauch erschwert es außerdem kleinen Teams, unabhängig KI-Modelle und -Anwendungen für das Gemeinwohl zu entwickeln. Auch wenn sich diese Probleme nicht ohne Weiteres lösen lassen, gibt es Wege, generative KI in Zukunft unabhängiger und klimafreundlicher zu entwickeln.

Was generative KI das Klima kostet

Besonders hoch ist der Ressourcenverbrauch zu Beginn, beim ersten Training von generativen KI-Modellen. Benötigt werden dafür neben großen Datensätzen auch teure Hardware bzw. Cloud-Dienste. Deren Nutzung ist mit einem hohen Verbrauch an Energie und Wasser und somit auch einem hohen Ausstoß von CO2-Emissionen verbunden. Kleinere Projekte sind häufig darauf beschränkt, vortrainierte Modelle durch sogenanntes Fine-Tuning für spezifische Nutzungskontexte anzupassen und in Anwendungen zu integrieren. Während die dafür benötigten Ressourcen deutlich unter denen liegen, die für die erste Entwicklung von generativen KI-Modellen benötigt werden, können sie dennoch deutlich höher sein als bei traditioneller Softwareentwicklung.

Gerade für große Softwareunternehmen hat die Effizienz ihrer KI-Modelle meist noch keine Priorität. Versuche, Kosten zu senken, beschränken sich oft auf die strategische Wahl günstiger Regionen oder Energiequellen für die Datenverarbeitung. Entsprechend werden auch die genauen Emissionen bisher selten systematisch und vergleichbar gemessen. Erste Anhaltspunkte zu den Emissionen von generativen KI-Modellen können allerdings Tools wie Code Carbon oder der ML CO2 Calculator geben.

Wer aktuell über generative KI bestimmt

Über zentrale Voraussetzungen für die Entwicklung von generativen KI-Systemen bestimmen heute wenige große, meist US-amerikanische Unternehmen. Diese verfügen über die technische Infrastruktur wie die Chipproduktion, Cloud-Dienste, große Datensätze und große, breit einsetzbare generative KI-Modelle. Diese Marktkonzentration führt sowohl zu finanziellen als auch zu technologischen Abhängigkeiten. Als Anbieter von Hardware und Cloud-Diensten, die für das Training, Fine-Tuning und den Einsatz von generativen KI-Modellen benötigt werden, können sie hohe Preise verlangen. Fehlende Interoperabilität führt außerdem zu Lock-in-Effekten – der Wechsel zwischen verschiedenen Cloud-Anbietern z. B. ist aufgrund ihrer jeweiligen technischen Besonderheiten aufwändig und somit teuer.

Technologische Abhängigkeiten bestehen auch, weil kleine Projekte in der Regel auf vortrainierten, großen generativen KI-Modellen aufbauen. Sie sind somit abhängig von der Bereitschaft großer Unternehmen, ihre Modelle über eine API nutzbar zu machen oder frei nutzbar zu veröffentlichen. Damit geben diese Unternehmen nicht nur wichtige technische Entscheidungen vor, sondern können Entwickler*innen auch wieder von ihren Technologien abschneiden, indem sie den Zugriff über API einstellen oder neue Modelle nicht mehr veröffentlichen.

Wie Ressourcenverbrauch und Abhängigkeiten reduziert werden könnten

Insgesamt haben Softwareentwickler*innen, die generative KI-Systeme nutzen und entwickeln wollen, aktuell wenig Aussicht darauf, das klimaschonend und unabhängig zu tun. Es gibt allerdings eine Reihe an Ideen, wie sich der Ressourcenverbrauch und Abhängigkeiten reduzieren lassen könnten. Ein Ansatz für kleine Projekte mit begrenzten Ressourcen könnte sein, sich auf die Entwicklung kleinerer, energieeffizienterer Modellarchitekturen zu konzentrieren.

Für das ressourcenintensive Training von KI-Modellen ist der Aufbau einer gemeinschaftlich organisierten und genutzten Infrastruktur vielversprechend. Eine gemeinsame Hardware- und Cloud-Infrastruktur könnte staatlich – wie in Kanada geplant – oder genossenschaftlich aufgebaut werden. Als Trainingsdaten bieten sich Offene Daten an, die z. B. durch Crowdsourcing oder staatliche Stellen der Allgemeinheit zur Verfügung stehen. Je nach Kontext könnte auch Federated Learning eine Lösung bieten, bei dem die Daten verschiedener Parteien dezentral und vertraulich für das Training genutzt werden. Um die Marktkonzentration im Bereich generativer KI-Modelle, -Anwendungen und der ihnen zugrundeliegenden Infrastruktur zu begrenzen, könnten zusätzlich auch weitere kartellrechtliche Schritte in Betracht kommen, wie sie vom Bundeskartellamt bereits geprüft werden.